动作捕捉系统用于准确测量运动物体在三维空间中的运动状态与空间位置。ErgoLAB Motion是shijielingxian的全新可穿戴运动捕捉与人机工效/生物力学分析系统,配备可穿戴人因记录仪,便于携带,非常适用于各种虚拟现实应用与实时的现场人因工效科学研究,如安全生产、人机交互、运动分析,动作姿势伤害评估等。

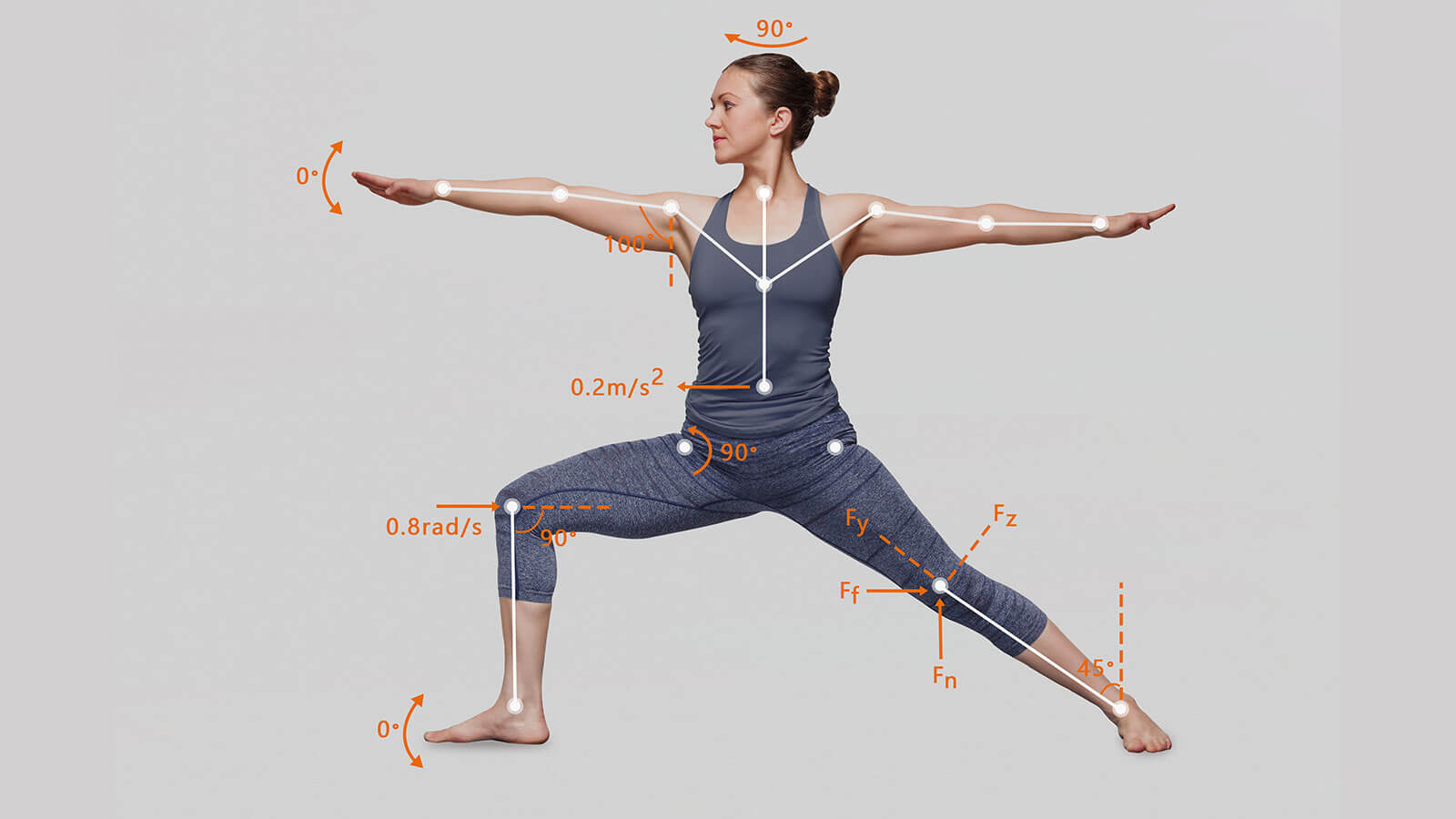

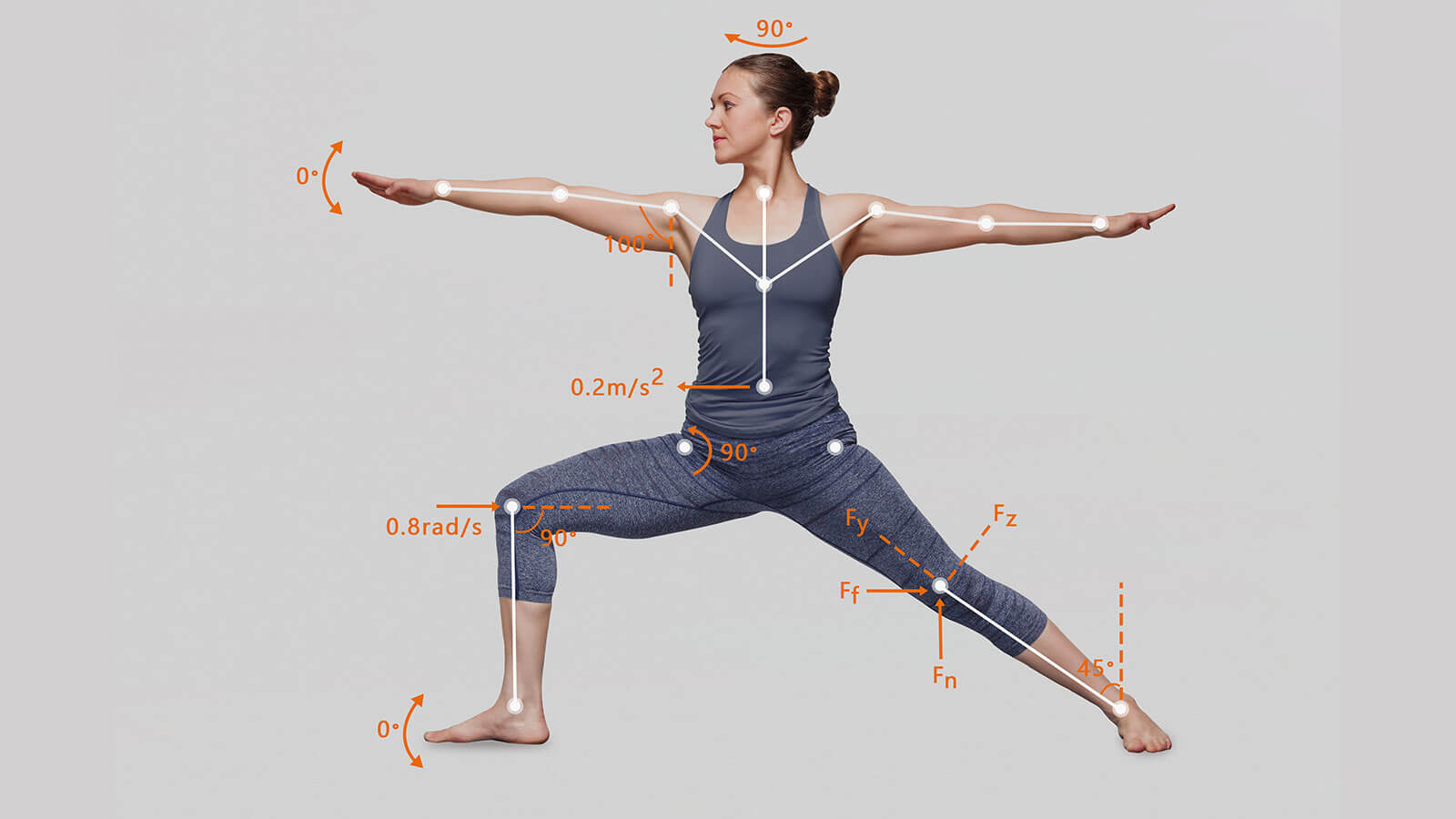

结合加速度、陀螺仪、方位传感器实时cai ji人体动作,位置,速度,关节角度,扭矩等信息不受环境、光线与空间距离的限制,配备无线人因记录仪便于携带,适合真实户外现场研究全世界抗电磁干扰能力***强、支持多人同时进行且数据稳定性效果***好的惯性IMU技术同时追踪操作人员的位置、距离和步数,无需额外标记即实现较为**的空间定位效果工效分析与姿势伤害评估:通过3D数字人实现对动作和姿势的实时风险评估与预警支持实时同步cai ji 多模态数据,包括眼动、脑电、生理、行为等,支持3D空间位置计算

数据cai ji与可视化分析

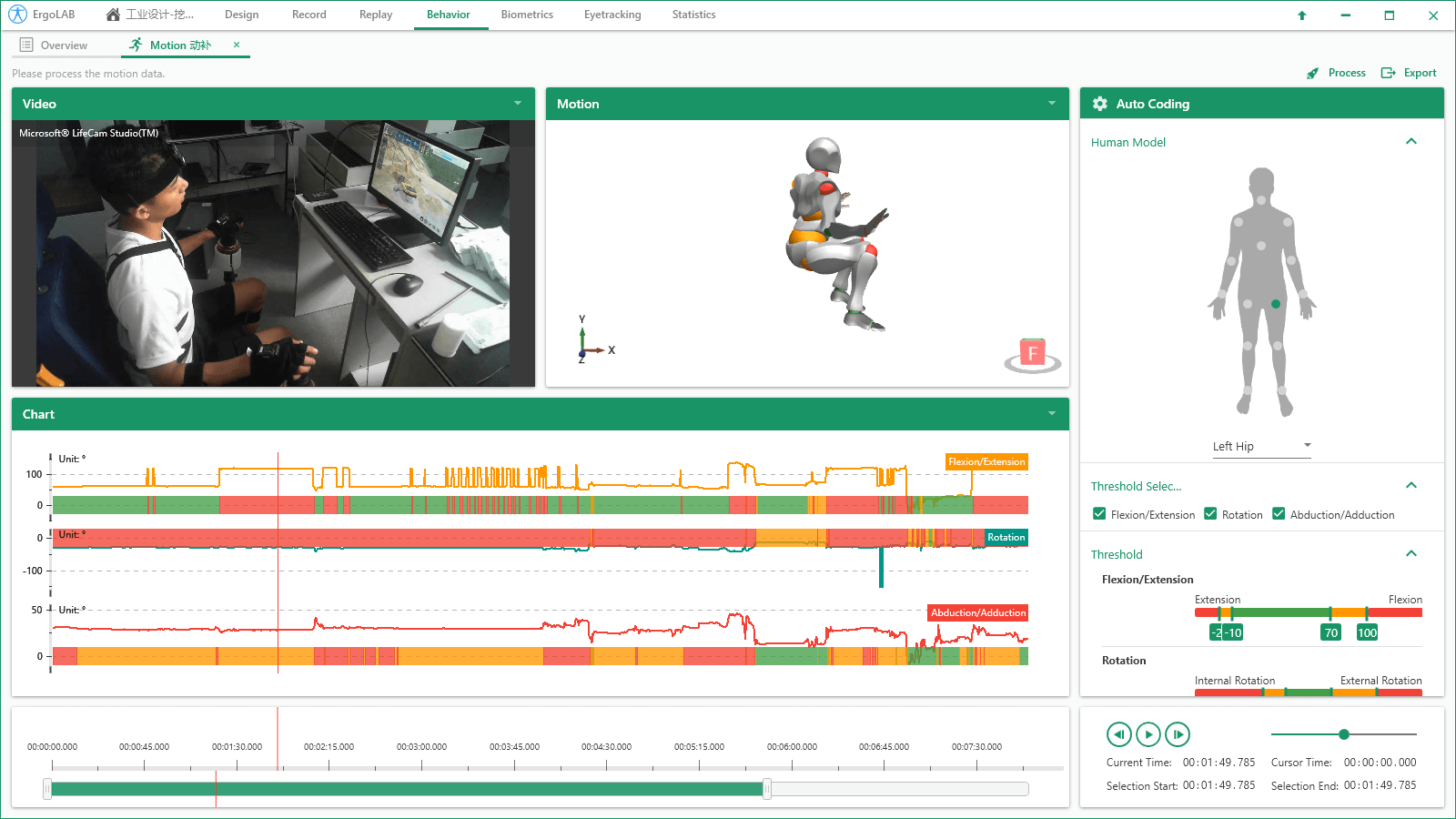

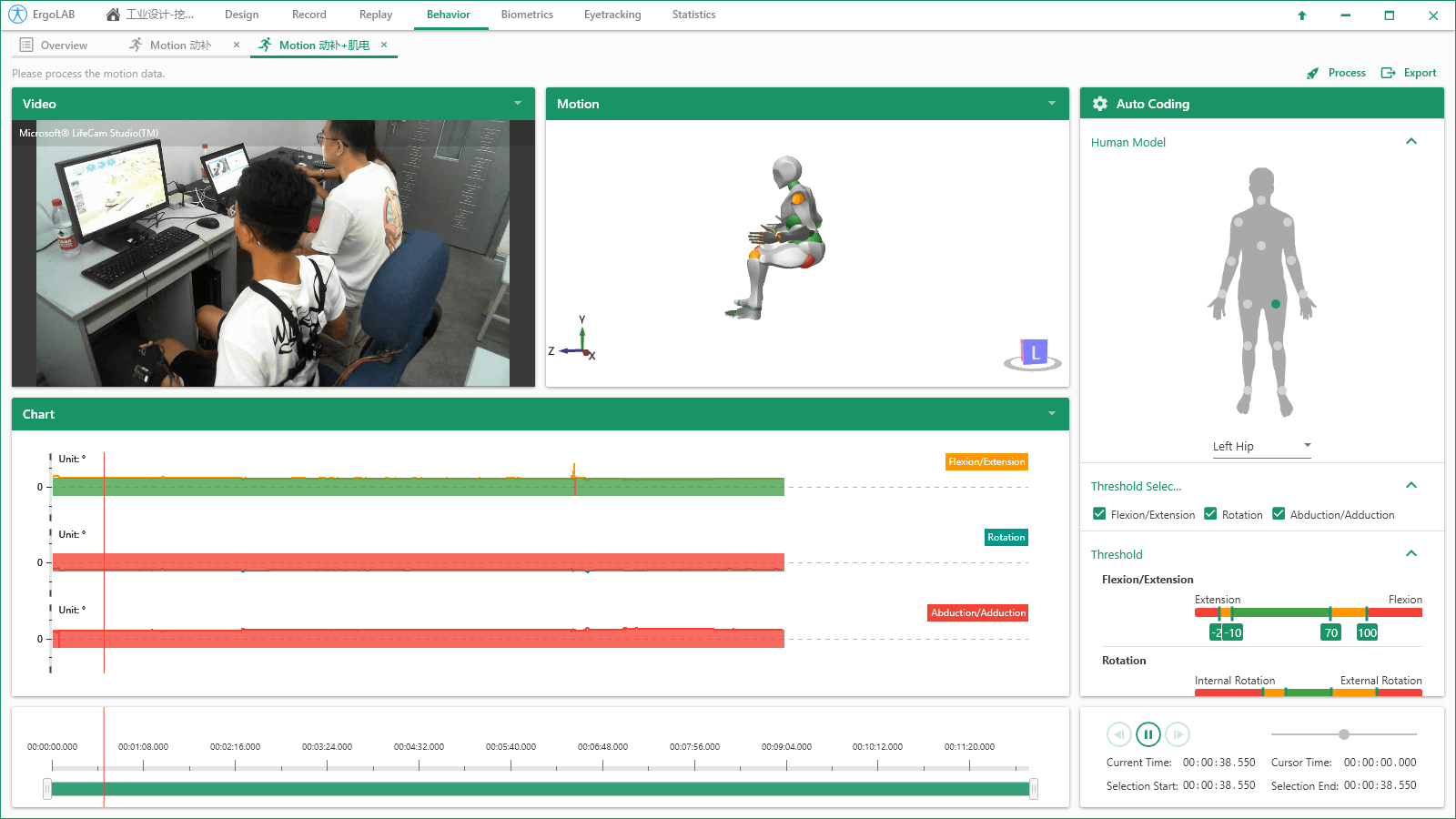

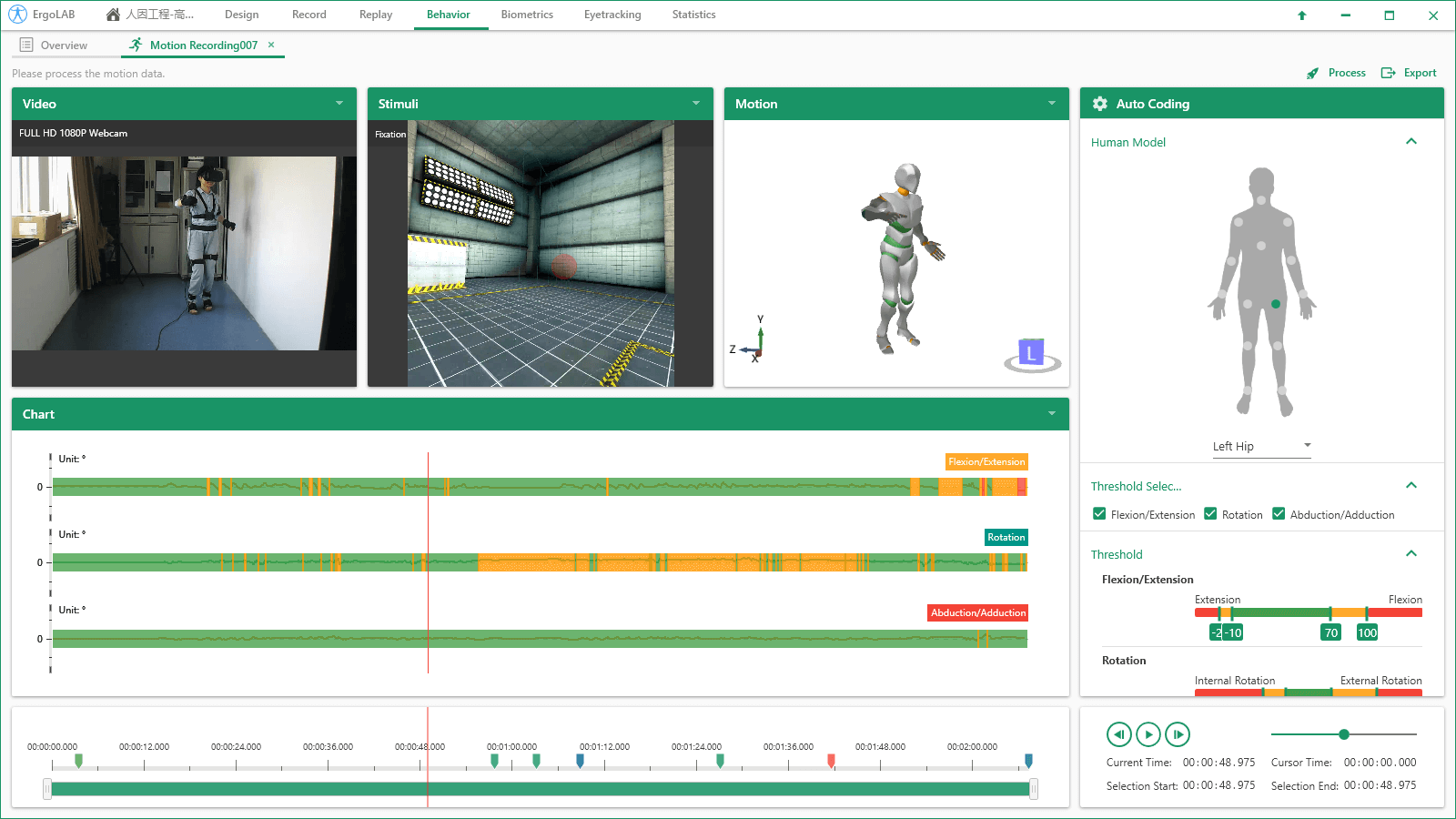

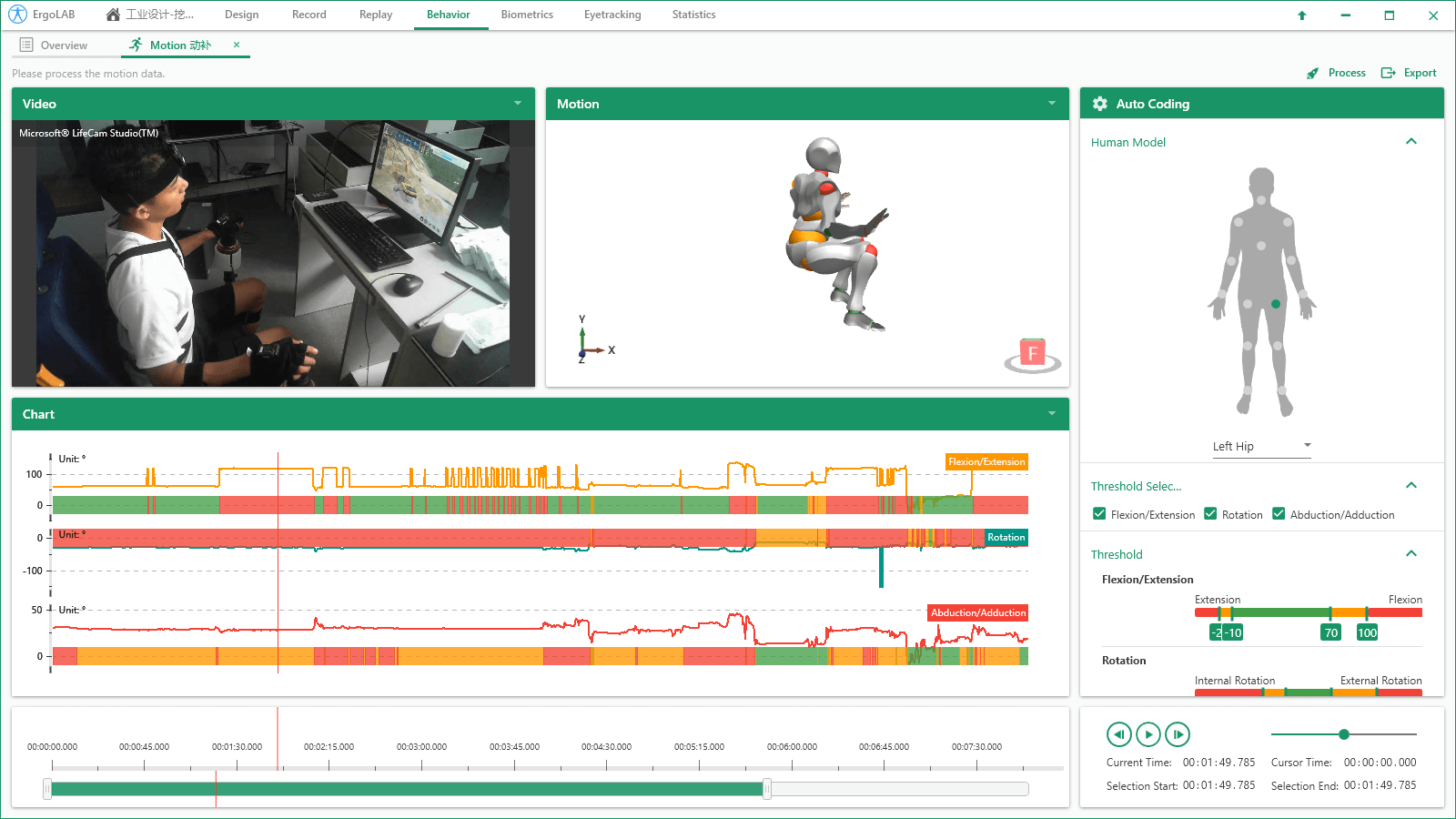

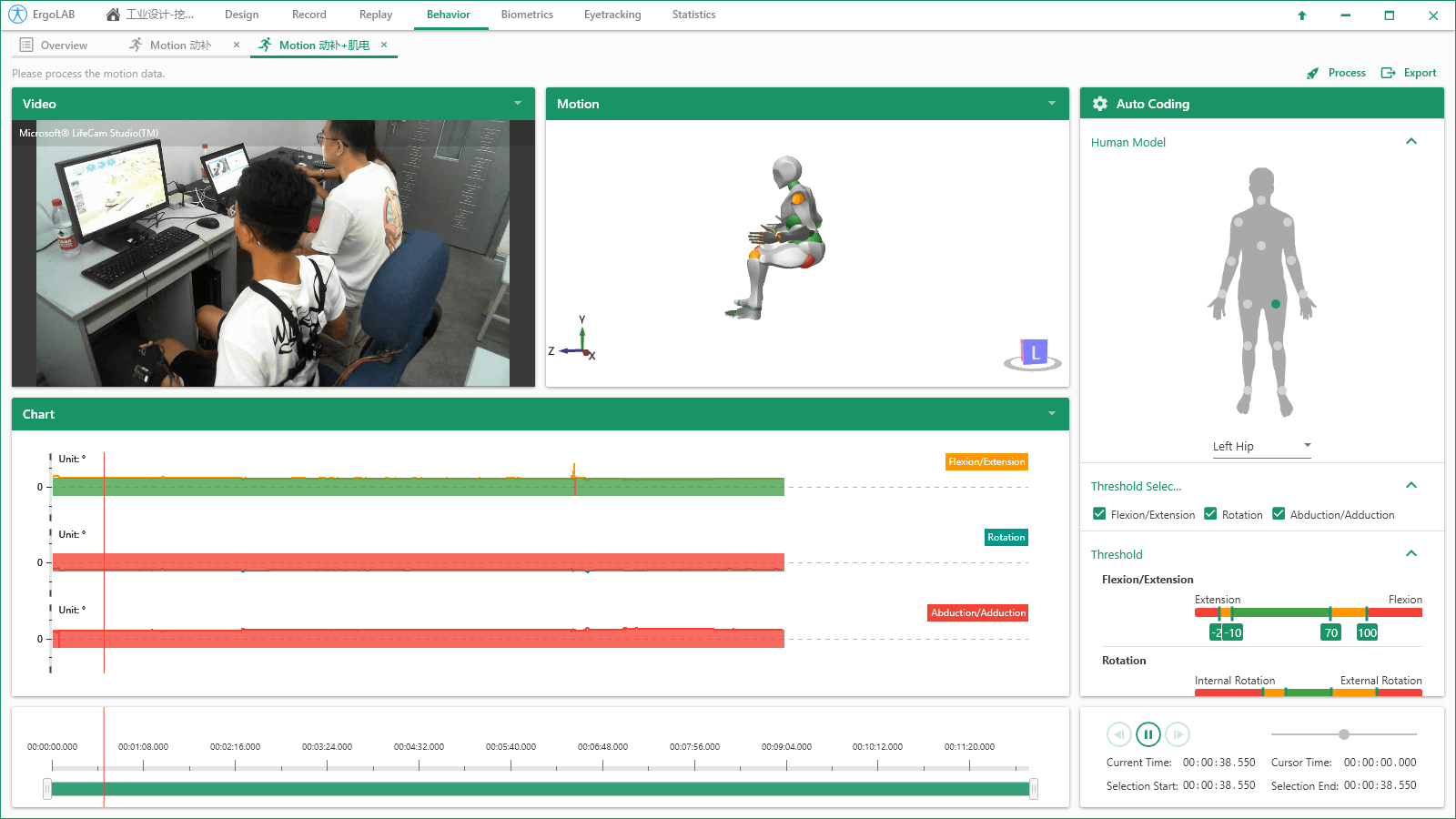

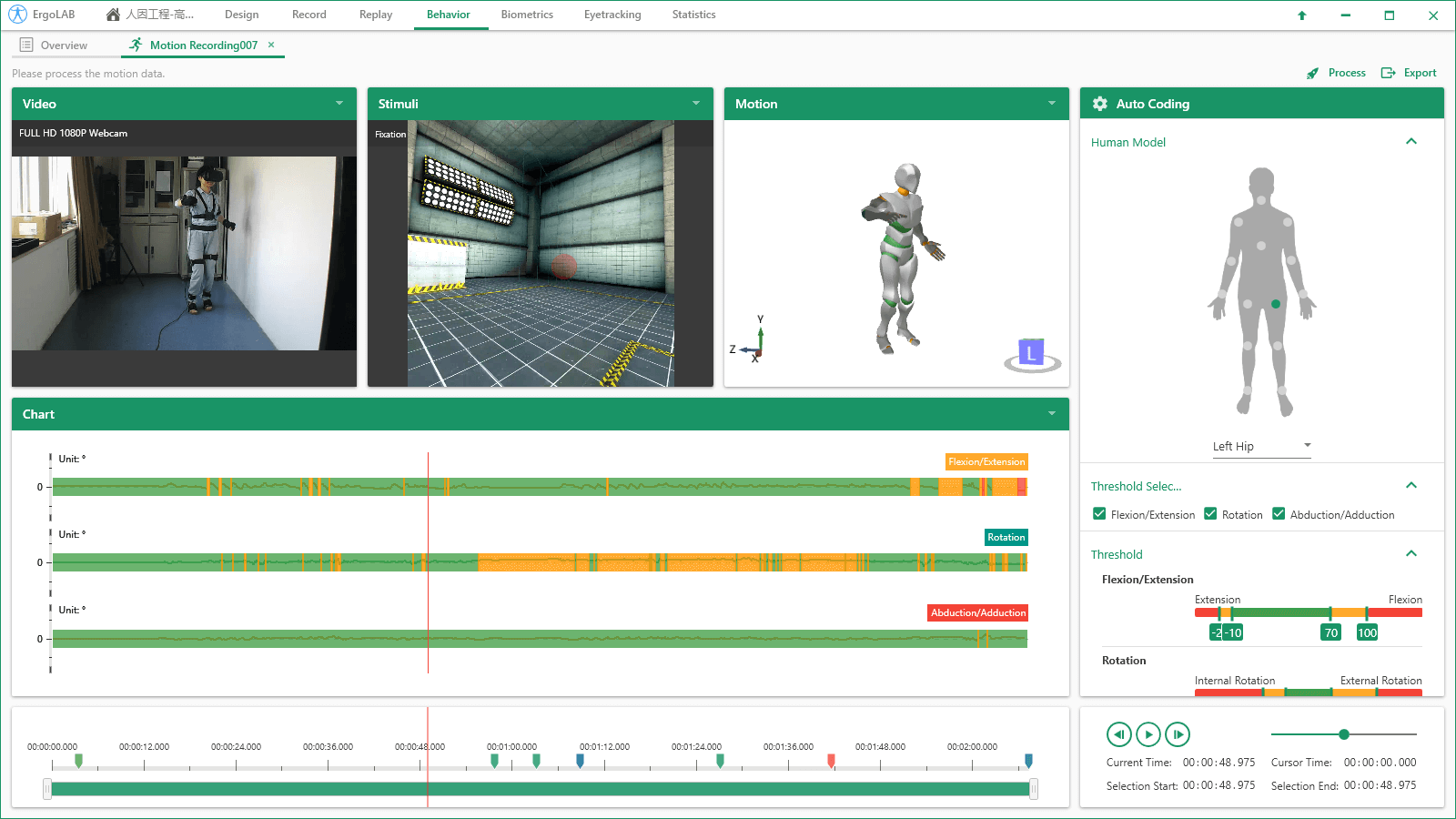

多种数据cai ji 与编码方式:支持实时数据传输以及Motion Datalog便携式数据cai ji仪cai ji,数据可后期导入系统中,与其他多元数据同步分析。支持实时姿态编码与后期手动编码。自定义处理参数:可以自定义设置身高数据,并包含完整的参数处理模块,如数据降噪、合并***短行为、自定义行为长度等,帮助用户可以找到目标动作与动作分类。可视化3D人体模型:通过动作捕捉传感器IMU中的加速度、磁力计、陀螺仪数据,计算人体动作,位置,速度,关节角度,扭矩等信息,jingque重塑个体的3D人体动作模型,实时或离线观察个体的运动姿态以及不同关节的运动情况。可视化数据编码:系统默认14个关节角度的安全度阈值范围,并自动识别并编码个体在动态作业过程中的实时关节角度数据,并进入行为数据统计分析。

动作行为数据交互分析

基础行为分析:计算统计每种动作行为状态发生的开始时间、结束时间、行为发生的持续时间、发生的次数、整个实验任务中的操作安全程度比例等数据统计。交互行为分析:自动识别两种或多种动作发生的交互关系,针对两种或多种行为同时发生的时间、次数、概率等数据指标进行统计。行为顺序效应分析:自动可视化分析一种动作发生在另一种动作之后/之前的动态关系,包括动作之间的延迟效应、顺序效应分析,并一键导出行为发生的可视化序列性分析报告。

动作姿势伤害评估

通过3D人体数据模型,实时监测14个关节位置分别对应的Flexion / Extension弯曲/伸展; Abduction / Adduction外展/内收;Rotation旋转以及 Angular Velocity角速度与 Angular Acceleration角加速度等,可实现对被试动作和姿势的实时视觉反馈以及风险姿势预警。依据职业工效学理论数据库常模,将人体姿态的各个关节角度阈值划分为健康(绿色)、警戒(红色)和中等(橘色)状态。系统可以自动化评估作业中影响工作效率的因素或可能造成职业伤害的动作。

多维度数据统计与二次开发

多维度数据交叉统计:系统支持动作捕捉数据与其他多模态数据(眼动、脑电、生理、行为、面部表情等)的同步交叉分析,多个数据源在同一平台界面呈现,在cai ji的同时间轴数据里选择相应的时间片段,可同步观察和统计分析所有数据流之间的相关关系。具有API开发接口:动作捕捉原始数据可以被其他程序实时访问,可使其它程序对被试者的各个关节9轴姿态进行计算与加工。 ErgoLAB人机环境同步云平台可人-机-环境多维度数据的同步cai ji与综合分析,包括眼动追踪、生理测量、生物力学、脑电、脑成像、行为、人机交互、动作姿态、面部表情、主观评 价、时空行为、模拟器、物理环境等,为科学研究及应用提供完整的数据指标。平台可完成完整的实验和测评流程,包括项目管理-试验设计-同步cai ji-信号处理-数据分析-人工智能应用-可视化报告,支持基于云架构技术的团体测试和大数据云管理。

企业特殊行业经营资质信息公示

企业特殊行业经营资质信息公示